By Lionel Gurret and Fabrice Vergnenègre.

Introduction

Les Kubernetes Community Days ont pris place dans les bureaux de Google à Zurich Europaallee pour la première fois en Suisse! Organisés par la Cloud Native Computing Foundation (CNCF), ces évènements mondiaux rassemblent des experts et adoptants de la communauté open source et cloud native.

La première journée était dédiée à des workshops pratiques où les participants ont pu mettre en pratique leurs compétences et apprendre auprès d’experts.

Dans cet article, nous allons nous concentrer sur la seconde journée des Kubernetes Community Days, en présentant un résumé des différentes présentations ainsi que les points clefs à retenir.

Alors, sans plus tarder, allons-y !

Talk 1: Cilium Mesh – How to Connect Kubernetes with Legacy VM and Server Infrastructure

Résumé

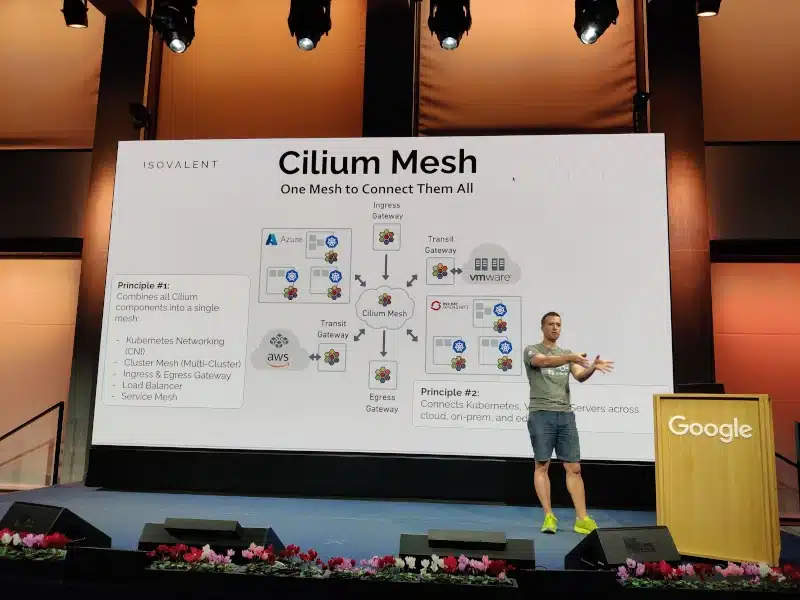

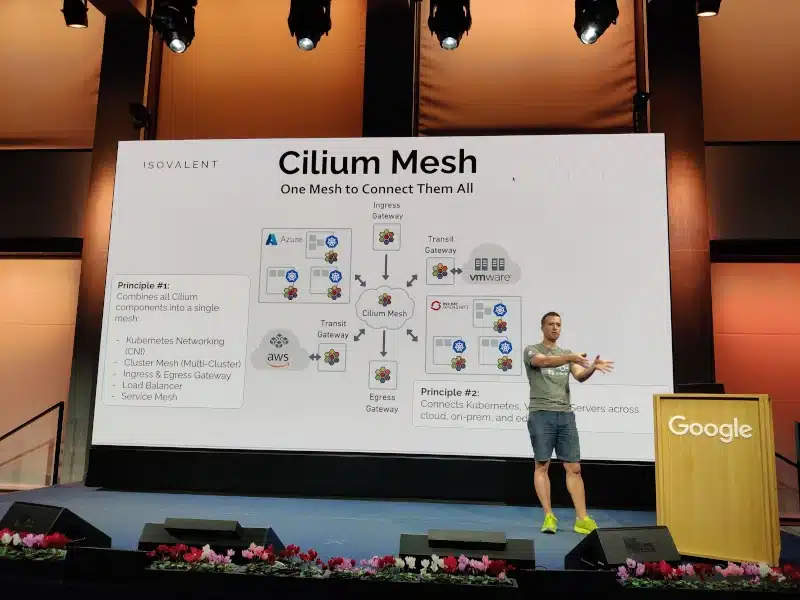

Kubernetes convient parfaitement aux charges de travail conteneurisées. Cependant, la majorité des charges de travail resteront où elles se trouvent encore un moment, s’exécutant sur des VM ou des serveurs physiques dans des environnements cloud publics ou privés. Comment pouvons-nous connecter le nouveau monde de Kubernetes, composé de services, d’identités et de CI/CD, avec le monde existant des VM, des serveurs et de l’infrastructure réseau ? Dans cette session, Thomas Graf examine la toute nouvelle couche Cilium Mesh. Cilium Mesh est une nouvelle couche de réseau universel qui permet de connecter les charges de travail et les machines à travers le cloud, les infrastructures sur site et les environnements de périphérie. Il comprend un composant de réseau Kubernetes (CNI), un plan de connectivité multi-clusters (Cluster Mesh) et une passerelle de transit pour se connecter aux VM et serveurs dans les réseaux existants.

Points clefs

- Cilium Mesh combine tous les composants de Cilium en un seul mesh :

- Kubernetes Networking (CNI)

- Cluster Mesh (Multi-Cluster)

- Ingress & Egress Gateway

- Load Balancer

- Service Mesh

- Cilium Mesh connecte Kubernetes, les VM et les serveurs à travers le cloud, sur site et en périphérie (edge).

- Le Cluster Mesh API Server contient une instance d’etcd pour suivre l’état du cluster. Les états de plusieurs clusters ne sont jamais mélangés.

- La découverte de service globale du modèle multi-cluster de Cilium est construite en utilisant les services standard de Kubernetes et est conçue pour être totalement transparente pour les déploiements d’applications Kubernetes existantes.

- Vous pouvez utiliser les Cilium Network Policies multi-cluster !

- La fonctionnalité de sécurité et d’observabilité Cilium Identity Aware Security vous permet d’observer et de sécuriser facilement vos applications indépendamment de leur emplacement.

Talk 2: The state of Green Washing – or how to build sustainable systems with Kubernetes

Résumé

Cette présentation portait sur la construction de systèmes durables avec Kubernetes. Bien que Kubernetes puisse être utile pour concevoir des systèmes respectueux de l’environnement, il est important de ne pas céder à la tentation du "green washing". La présentation a examiné les possibilités actuelles, les développements récents et les besoins futurs pour créer un paysage de système respectueux de l’émission carbone. Les participants ont appris comment la conception d’architectures de système respectueuses de l’environnement peut avoir un impact durable.

Points clefs

- Différents challenges :

- consommation énergétique des datacenters

- augmentation exponentielle des données sur du hardware obsolète

- les émissions carbones sont partout

- Ce que l’on peut faire :

- optimiser la taille de ses images pour ses conteneurs

- planifier des conteneurs pour une densité élevée

- mettre à l’échelle des conteneurs à zéro

- mettre à l’échelle des clusters à zéro

- optimiser les nœuds, le matériel (par exemple, basé sur ARM) et le système d’exploitation (OS)

- Ce que l’on doit faire :

- un futur sans conteneur

- planifier en fonction des émissions de carbone

- mettre à l’échelle en fonction des émissions de carbone

- concevoir des architectures pour la durabilité

- améliorer la gestion de l’énergie

- Comment réduire son empreinte carbone :

- mettre à l’échelle, réduire et ajuster la taille des ressources

- changer le matériel ou l’architecture de calcul

- ajuster l’architecture des systèmes

- optimiser les logiciels et le processus de construction

Talk : Forensic container checkpointing and analysis

Résumé

La fonctionnalité de "Forensic Container Checkpointing" dans Kubernetes 1.25, permet la création d’un point de contrôle d’un conteneur en cours d’exécution. Ce point de contrôle peut être utilisé pour une analyse afin de comprendre l’état du conteneur à un moment précis. Cela peut être utile dans les situations où il peut y avoir une faille de sécurité ou un autre problème nécessitant une enquête.

Cette fonctionnalité offre de nombreuses nouvelles possibilités, comme la migration de conteneurs sans perdre leur état, un démarrage rapide à partir de checkpoints existants ou une utilisation plus efficace des instances Spot.

Points clefs

- Technologie de checkpoints permettant un snaphsot du process (pages mémoire, mounting points, registres cpu, process state)

- Permet l’investigation et le debug des process des containers

- Permet surtout le déplacement des containers "stateful" d’un noeud à l’autre, avec une interruption minime de service

- Pour l’instant uniquement disponible dans la technologie RedHat (CRI-O avec runc ou crun)

- Des pull requests dans containerd et kubernetes sont en cours

- On attend avec impatience cette technologie en mode kubernetes natif, avec le support au niveau scheduler, qui pourra enfin fournir l’équivalent du V-Motion du VmWare pour les machines virtuelles au niveau des containers stateful.

Coffee Break

Talk : When Things Get Big: Scaling Cloud Native Workloads and Software Distribution

Résumé

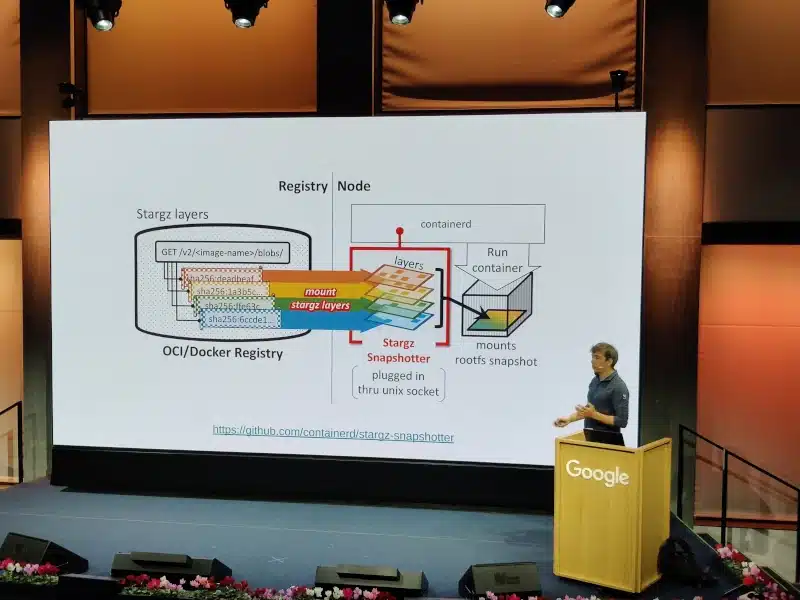

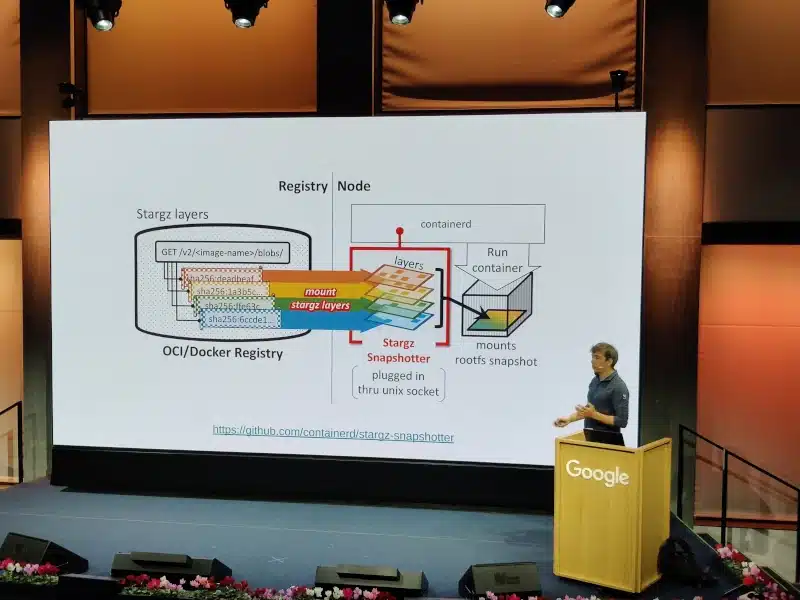

La transition vers les conteneurs a considérablement amélioré le déploiement et la gestion des services et des charges de travail dans les infrastructures informatiques à grande échelle. Cependant, cela a également introduit de nouveaux défis qui peuvent nécessiter des changements intrusifs dans les flux de travail ou être dissimulés dans la pile logicielle. Cette session se concentre sur l’un de ces défis et explique en détail comment distribuer efficacement des packages logiciels très volumineux sur des milliers de nœuds pour les charges de travail de batch, de calcul intensif ou d’apprentissage automatique.

Points clefs

- Les chiffres de l’utilisation des cluster Kubernetes au CERN donnent le vertige:

- 40M d’images de collisions de particules à stocker par seconde

- Une ferme entière est présente au sein du détecteur de collisions, afin de pouvoir effectuer le filtrage d’1PB/s d’information à 10GB/s d’information

- 3000 noeuds

- Les challenges sont nombreux, et dans ce talk, l’auteur se focalise sur un des challenges concernant la taille des images des applications hébergées sur les clusters: taille typique de 61GB, la plus large avoisinant les 124 GB

- Cela crée un vrai souci de latence de démarrage des applications, alors que le cluster doit pouvoir réagir dans des délais très brefs à des démarrages massifs de jobs (245K jobs)

- La solution présentée consiste en une réécriture du système de provisionning des layers du container engine, qui va démarrer avec des layers minimums et demander les fichiers du container uniquement lorsque le container en a réellement besoin. Une sorte de lazy-loading des fichiers, basé sur stargz-snapshotter.

- La démo est impressionante, avec une comparaison des démarrages d’applications:

- 5s vs 50s

- Des pics de bande passante à plusieurs centaines de MB/s dans le cas non optimisé, contre une bande passante plus étalée dans le temps, autour d’une vingtaine de MB/s.

Talk : Demystifying eBPF – eBPF Firewall from scratch

Résumé

L’eBPF est de plus en plus utilisé dans l’écosystème cloud-native, notamment pour implémenter des pare-feux haute performance et d’autres fonctionnalités de sécurité. Filip explore les concepts fondamentaux de l’eBPF et montre comment construire un pare-feu à partir de zéro en utilisant cette technologie. En présentant des exemples concrets d’utilisation de l’eBPF dans des projets CNCF tels que Cilium, Calico et Pixie, il nous aide à mieux comprendre comment l’eBPF peut être appliqué à différents cas d’utilisation.

Points clefs

eBPF (Extended Berkeley Packet Filter) est une technologie kernel qui permet aux programmes d’être exécuté sans devoir modifier le code source du kernel ni ajouter de modules supplémentaires.

Nous avons vu qu’il était relativement simple de mettre en place un script pour le tester.

Exemple de code pour un firewall bloquant tout le traffic entrant :

SEC("xdp_kcd_zurich")

int xdp_kcd_zurich_firewall(struct xdp_md *ctx)

{

// drop all packets

return XDP_DROP

}

eBPF est :

- Axé sur les événements

- Polyvalent

- Rapide

- Sécurisé

- De plus en plus populaire

Talk : Responsible AI: The Key to Ethical, Safe and Inclusive Software Development

Résumé

Ce talk aborde l’importance de l’IA responsable pour le développement éthique et inclusif des logiciels. Lisa présente des frameworks pour le développement d’IA éthique et interprétable, en se basant sur une expérience de développement de l’apprentissage automatique dans le domaine médical. Les principes de l’IA responsable peuvent être étendus au développement de logiciels en général pour assurer une approche plus inclusive et bénéfique pour la société, et minimiser les conséquences négatives.

Points clefs

- Un framework complet et appliqué chez Zuhlke pour de la vraie gouvernance des projets et applications de l’AI centré sur:

- L’Humain: la définition des risques du projet, l’assignation claire de la responsabilité, la transparence sur les limites du modèle, et l’obligation de monitorer en continu l’utilisation du modèle

- Les Données: les modalités de collecte, le respect de la vie privée, l’obligation d’analyse des biais involontaires ou malicieux, les conditions de partage et d’utilisation de ces données

- Les Modèles: la définition non ambigue des critères de succès, la validation des modèles, et notamment le lien avec les essais cliniques obligatoires dans le monde de l’application AI dans le domaine médical

- En conclusion, il y a beaucoup (trop?) d’attentes vis-à-vis du EU AI Act qui sera publié à la fin de l’année 2023, définissant un modèle de classification des applications par niveau de risque et très certainement des exigences à respecter pour chacun des niveaux identifiés.

Talk : What Anime Taught Me About K8s & Tech Careers

Résumé

Le talk d’Annie porte sur ce que l’anime peut nous apprendre sur la carrière dans le développement de Kubernetes et la technologie. Elle aborde l’importance de la persévérance, de l’inclusion, de la diversité ainsi que de toujours avoir une collation à portée de main. La présentation fournit également des astuces pour les débutants pour commencer leur parcours cloud native. Il est intéressant devoir comment l’anime peut booster sa carrière dans le développement de Kubernetes et de la technologie !

Points clefs

Beaucoup d’analogies peuvent être trouvées entre Kubernetes et les animes.

Différentes leçons apprises par Annie Talvasto:

- L’importance du travail en équipe

- Développement personnel

- Rester à l’écoute

- Documenter

- Croire en soi

Lunch

Talk : Buzzing Across the Cloud Native Landscape with eBPF

Résumé

Bill explique comment il est entré dans le monde d’eBPF et comment cette technologie est utilisée dans le paysage cloud natif. Il montre comment eBPF permet une efficacité de mise en réseau, une observabilité sans instrumentation, une traçabilité facile et une sécurité en temps réel. Les participants repartiront avec une meilleure compréhension de la technologie eBPF et des outils disponibles pour résoudre des problèmes en matière de mise en réseau, d’observabilité et de sécurité.

Points clefs

- Un panorama complet des différents outils et technologies en orbite du phénomène eBPF:

- Inspektor Gadget

- Pyroscope (acquis par Grafana)

- Pixie

- Parca

- bpftrace

- bcc

- Optimyze

- Katran, le load balancer de Facebook

Talk : Streamlined Troubleshooting in Kubernetes

Résumé

Dans cette présentation, Lena met en évidence les différentes méthodes pour rendre le débogage et la résolution de problèmes dans Kubernetes plus efficaces et organisés. Elle montre différentes techniques et outils open source qui permettent de mieux comprendre les erreurs courantes et de résoudre les problèmes plus facilement en suivant des stratégies claires de résolution et en utilisant des outils d’automatisation. La présentation comprend également une démonstration en direct de certains de ces outils.

Points clefs

- La méthode la plus courante pour debugger un problème sur un pod ou un deployment :

kubectl get deploymentskubectl get podskubectl describe pod xxxkubectl log xxx

- La documentation Kubernetes contient tout le nécessaire pour debugger chaque type de ressource.

- La commande

kubectl get events --filed-selector type=Warning peut s’avérer utile.

- Outils de debugging :

- stern : Pour suivre plusieurs pods sur Kubernetes et plusieurs conteneurs au sein du pod, chaque résultat est codé en couleur pour un débogage plus rapide.

- k8sgpt : Un outil pour analyser vos clusters Kubernetes, diagnostiquer et résoudre les problèmes en langage simple en anglais.

- livelint : pour vous aider à debugger sur Kubernetes.

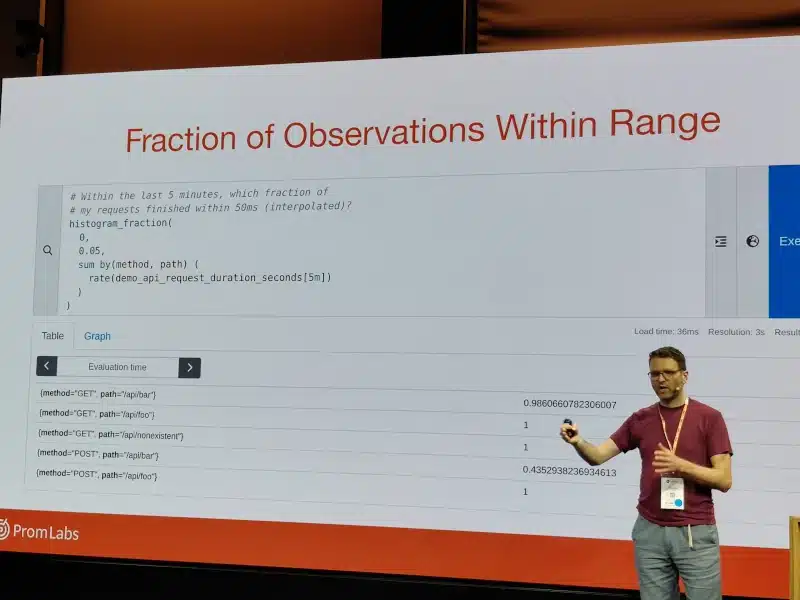

Talk : Native Histograms in Prometheus: A Better Histogram Experience for Everyone

Résumé

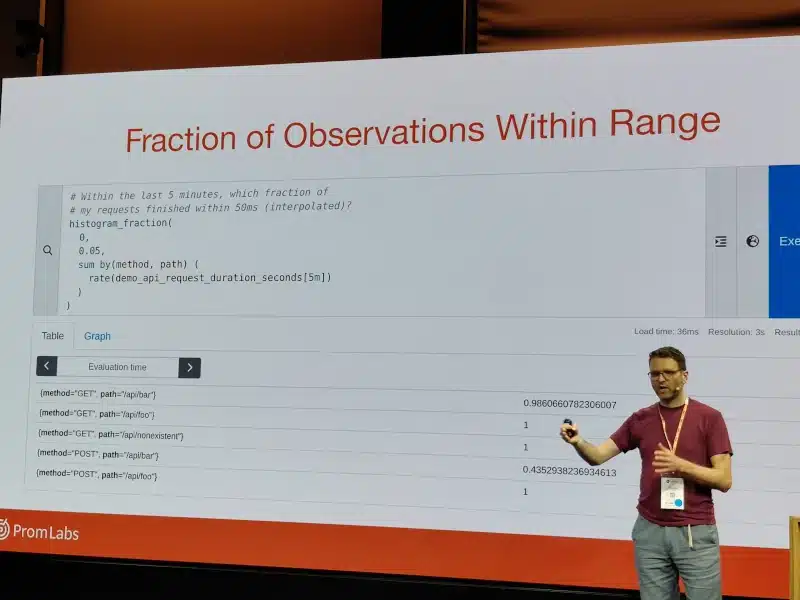

Dans cette présentation, Julius Volz, co-fondateur de Prometheus, présente les "histogrammes natifs", une nouvelle méthode pour suivre les distributions de valeurs avec plus de détails et à moindre coût de stockage et de traitement dans Prometheus. Contrairement aux histogrammes "legacy" existants, les histogrammes natifs nécessitent moins de configuration manuelle des buckets et génèrent moins de séries temporelles. Julius explique comment les histogrammes natifs fonctionnent et comment les utiliser expérimentalement dès maintenant dans Prometheus.

Points clefs

- Les histogrammes actuels dans Prometheus sont clairement une entorse au système de métriques basé sur des valeurs float associées à un timestamp

- Les buckets doivent être connus à l’avance, ce qui est un gros souci pour avoir des histogrammes avec des buckets cohérents (qui est capable dans son application de connaître a priori les bons buckets pour sa latence ????)

- Depuis peu, Prometheus a enfin adopté un format spécifique pour les histogrammes, ceci étant encore une feature expérimentale:

- les buckets sont définis de manière exponentielle

- la technologie supporte les buckets épars en ne les diffusant pas

- pour éviter l’accumulation de buckets quasi vides au cours du temps, un mécanisme de reset des buckets (par intervalle de temps, nombre max de buckets) est inclus dans les librairies d’instrumentation (golang uniquement pour le moment)

- Enfin! Depuis des années nous attendons une implémentation proche des HDR Histograms permettant de capturer et caractériser correctement l’information de latence. C’est maintenant chose faite!

Talk : Tales of Serverless – a story about building scalable applications

Résumé

Dans cette présentation, Reto raconte une histoire sur la création d’applications Serverless scalables. À l’aide de la plateforme Knative Serverless, il présente des applications qui apparaissent et disparaissent. Il explore l’écosystème Serverless et ses mécanismes. À la fin de cette présentation, nous devrions être en mesure de comprendre les mécanismes.

Points clefs

- Knative est un projet de la communauté Open Source qui ajoute à Kubernetes des composants pour le déploiement, l’exécution et la gestion des applications cloud-native serverless.

- Knative facilite la création d’applications serverless sur Kubernetes.

- L’approche serverless permet d’exécuter du code sans avoir à se soucier de l’infrastructure sous-jacente, en laissant à Knative la responsabilité de la gestion des ressources et de l’évolutivité automatique.

- Knative permet la mise à l’échelle automatique des conteneurs à l’aide d’un modèle basé sur les requêtes pour servir les charges de travail à la demande. Nous avons vu ensemble la possibilité de laisser un déploiement scalé à 0 sans perturber le fonctionnement de l’application.

- Les applications peuvent être déclenchées par différentes sources telles que des événements issus de vos propres applications, des services cloud de nombreux fournisseurs ou des systèmes SaaS.

- Autres fonctionnalités Knative :

- Request buffering pour éviter la surcharge de l’application

- Diverses cibles de trafic (mise à l’échelle) telles qu’un taux de demande maximal fixe

- Routage basé sur des tags

- Configuration et révisions

- Métriques et observabilité

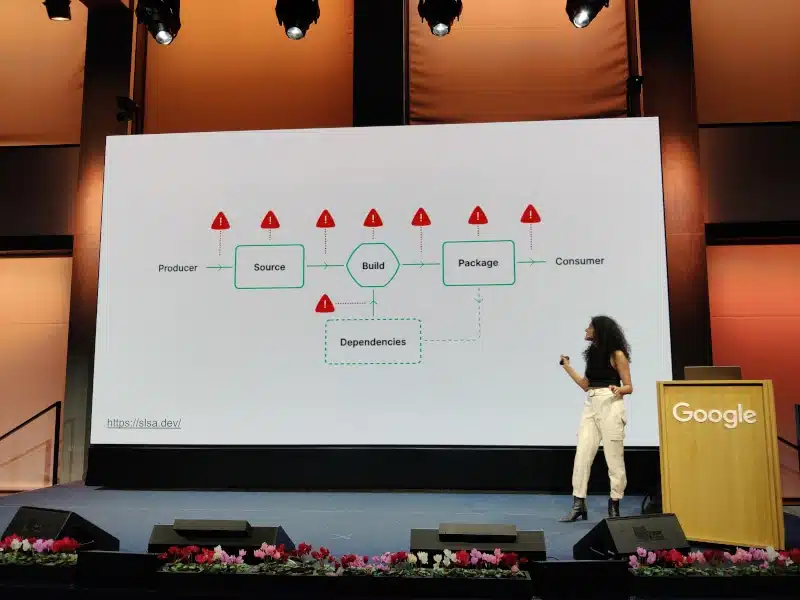

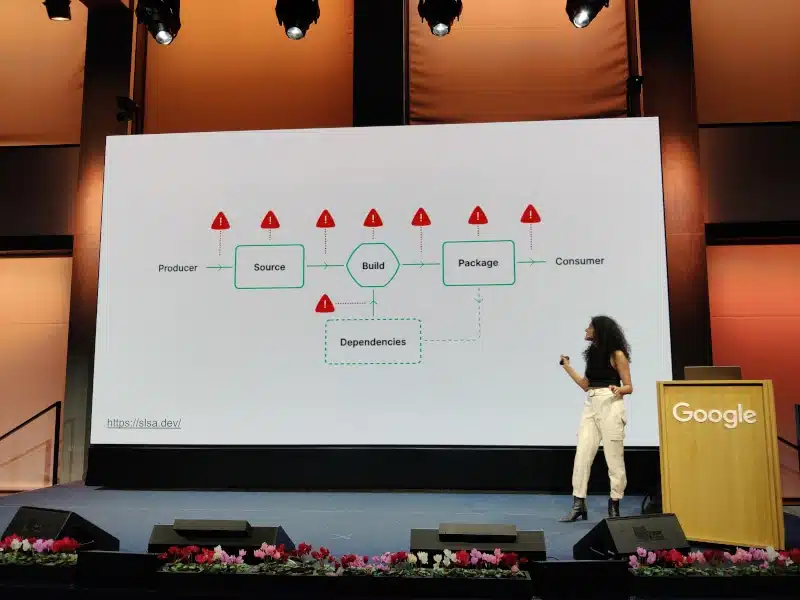

Talk : Securing your Software Supply Chain on Kubernetes with Sigstore

Résumé

Dans cette présentation, Priya Wadhwa aborde la question de la sécurité des images exécutées dans votre cluster Kubernetes. Elle explique comment déterminer la composition et le risque de vulnérabilité de vos images, et comment les sécuriser en utilisant la signature de conteneurs via Sigstore. Elle présente également comment appliquer les principes SLSA (Software Supply Chain Security) pour sécuriser votre pipeline de construction, et comment faire respecter les politiques associées à vos images au sein de votre cluster Kubernetes avec le contrôleur de politique Sigstore.

Points clefs

- Sigstore est un projet de boîte-à-outils permettant la vérification de l’authenticité et la provenance d’une image et/ou de ses données

- La signature est traditionnellement organisée autour de la génération de paire de clés

- Sigstore change un peu le paradigme:

- L’image est associée à une identité (supportée par OIDC)

- La génération d’une paire de clés à durée limitée qui sera inscrite dans un registre (Fulcio)

- Un registre transparent des opérations est gardé à jour (Rekor)

- Un Admission Controller pour Kubernetes est fourni, permettant d’évincer les images non signées, non authentiques, qui ne viennent pas de registry spécifiques, ou qui ont des vulnérabilités attestées

- La demo très complète de toute la chaîne, depuis la génération de l’image (basée sur nginx et scannée par trivy, avec le résultat du scan attesté dans la registry) jusqu’à son éviction sur le cluster est très convaincante.

- Néanmoins la question de la durée de validité du scan de vulnérabilité n’est pas adressée. En revanche, Priya donne déjà des éléments de réponse en parlant de la SBOM plutôt que le résultat du scan. C’est un thème que nous avons abordé en détails dans notre talk How to protect yourself from a “Supply Chain Attack”? aux DevOps D-Days 2022

Talk : Closing the Developer Experience Gap of your Container Platforms

Résumé

Dans cette présentation, Timo parle de la difficulté pour les développeurs de travailler avec les plateformes de conteneurs en raison d’un manque de convivialité pour les utilisateurs. Il explique que les développeurs doivent souvent avoir des connaissances approfondies en matière de conteneurs et de Kubernetes pour déployer leurs applications, ce qui peut prendre beaucoup de temps. Dans cette présentation, Timo présentera plusieurs technologies open source, comme Backstage, Cloud Native Buildpacks, Knative et Cartographer, qui peuvent aider à combler cette lacune en matière d’expérience utilisateur et permettre aux développeurs de se concentrer sur l’ajout de valeur métier.

Points clefs

Plusieurs outils ont été passé en revue :

- Les Cloud Native Buildpacks sont un ensemble d’outils et de conventions qui permettent de créer des images de conteneurs à partir du code source de votre application de manière plus simple et plus cohérente. Plutôt que de devoir écrire des Dockerfiles ou des scripts de construction complexes, les Cloud Native Buildpacks automatisent le processus de création d’images de conteneurs en analysant votre code source et en le combinant avec les dépendances nécessaires pour créer une image finale prête à être exécutée.

- Kpack est un projet open source qui apporte cette fonctionnalité de Cloud Native Buildpacks à Kubernetes. Il s’agit d’une approche "native" à Kubernetes pour la création d’images de conteneurs à partir du code source de votre application.

- Kpack utilise les Cloud Native Buildpacks en tant que moteur de construction pour générer automatiquement des images de conteneurs à mesure que votre code source évolue.

- Avec Kpack et les Cloud Native Buildpacks, vous pouvez bénéficier d’une méthode plus simple et plus automatisée pour créer des images de conteneurs à partir de votre code source. Cela vous permet de vous concentrer davantage sur le développement de votre application sans vous soucier des détails de construction d’images. Vous pouvez ainsi déployer facilement vos applications sur Kubernetes et les exécuter sur n’importe quel cloud de manière portable.

- Knative facilite la création d’applications serverless sur Kubernetes

- Cartographer est un outil qui permet de cartographier et de visualiser le flux de travail de développement et de déploiement continu de manière claire et compréhensible.

- Backstage fournit une interface centralisée pour la gestion des services, des pipelines de déploiement et des informations liées au développement, offrant ainsi une vue d’ensemble du cycle de vie des applications.

Talk : Process is what naturally follows – a cloud platform’s guide on people-first transformation

Résumé

Dans cette présentation, Sebastian aborde la transformation des entreprises en mettant les personnes au premier plan. Il explique comment la transformation peut être rendue possible en la transformant en un argument commercial. Sebastian parle également du temps de mise sur le marché et de l’importance de changer les paradigmes culturels.

Points clefs

- La transformation par les process résultera dans des personnes qui sont conformes au process

- La transformation par les personnes résultera dans des personnes qui résolvent des problèmes

- Les outils et leur utilisation arriveront naturellement pour résoudre des problèmes réels

- La standardisation en process doit émerger par la suite: un "golden path" naturel pourra être encouragé car il aura capturé naturellement le savoir-faire de l’entité

- La déviation du Golden Path doit être possible, moyennant une présentation argumentée de pourquoi un groupe pense qu’il est vital pour son business case d’adopter des pratiques, outils ou process différents

Talk : Bridging Dev and Ops with eBPF: Extending Observability Upwards and Downwards

Résumé

La présentation de Raphaël Pinson porte sur l’utilisation d’eBPF (extended Berkeley Packet Filter) pour améliorer l’observabilité dans les systèmes Linux. En utilisant eBPF, il montre comment cela peut combler le fossé entre les équipes de développement et d’opérations en fournissant des informations plus approfondies sur le noyau, les systèmes d’exploitation et les applications en cours d’exécution. La présentation couvre également la façon dont eBPF peut être utilisé pour étendre l’observabilité vers le bas en accédant aux informations système de bas niveau et vers le haut en offrant des capacités de traçage au niveau de l’application.

Points clefs

- Du monitoring basique à l’expertise

- Apportez des métriques aux développeurs et le droit de déployer

- Plus de métriques avec eBPF

- eBPF : rend le noyau Linux programmable de manière sécurisée et efficace

- Cas d’utilisation d’eBPF : protection contre les attaques DDOS, équilibrage de charge, patching en direct du noyau

- Cilium

- Amélioration des performances (pas d’iptables, contournement TCP/IP)

- Architecture plus simple (pas de proxy sidecar pour le service mesh)

- Hubble

- Observabilité fine-grain du réseau

- Exportation vers SIEM

- Support de la norme OpenTelemetry

- Tetragon

- Observation et exportation des événements du noyau

- Action sur les événements (par exemple, SIGKILL)

Talk : eBPF for Security

Résumé

Liz revient sur les fondamentaux d’eBPF et notamment en quoi la technologie est particulièrement intéressante du point de vue de la sécurité. De par son positionnement bas niveau, eBPF permet d’observer les évènements typiques d’une utilisation malicieuse d’un container qui a été compromis: appels au système de fichier, ouverture de connections, etc…

Points clefs

Conclusion

Les KCD Zurich furent un événement exceptionnel où de nombreux experts et professionnels ont partagé leur expérience et leurs connaissances sur les dernières tendances en matière de conteneurisation et de Kubernetes. Grâce à la très grande qualité des talks, nous avons appris beaucoup de choses sur la sécurité des conteneurs, la mise en place de politiques de conformité, la facilitation de l’expérience des développeurs, eBPF et bien plus encore. Nous espérons que ce résumé a été utile pour nos lecteurs et nous sommes impatients de revenir à l’avenir pour le prochain événement KCD.